Allgemeiner ZFS unter Debian Faden.

- Routerdilettantin

- Beiträge: 35

- Registriert: 09.11.2020 12:44:45

- Lizenz eigener Beiträge: GNU General Public License

Re: Allgemeiner ZFS unter Debian Faden.

Hallo @all,

ist für (m)ein Embedded System (Firewall m. pfSense/FreeBSD, 32 GB SSD mit 4 TBW, 24 GB für / (root), ohne Swap, Rest unpartitioniert wg. Overprovisioning/Haltbarkeit SSD, 8 GB RAM, davon ab geht 2 GB RAMDisk) ZFS wegen COW (hoffentlich problemloser Stromausfall ohne UPS) ratsam? Ansonsten nehme ich UFS, Linuxer wohl extX, was für Flash bewährt war. Danke übrigens für den interessanten Thread!

ist für (m)ein Embedded System (Firewall m. pfSense/FreeBSD, 32 GB SSD mit 4 TBW, 24 GB für / (root), ohne Swap, Rest unpartitioniert wg. Overprovisioning/Haltbarkeit SSD, 8 GB RAM, davon ab geht 2 GB RAMDisk) ZFS wegen COW (hoffentlich problemloser Stromausfall ohne UPS) ratsam? Ansonsten nehme ich UFS, Linuxer wohl extX, was für Flash bewährt war. Danke übrigens für den interessanten Thread!

- Lord_Carlos

- Beiträge: 5578

- Registriert: 30.04.2006 17:58:52

- Lizenz eigener Beiträge: GNU Free Documentation License

- Wohnort: Dänemark

Re: Allgemeiner ZFS unter Debian Faden.

@Routerdilettantin

Was hat FreeBSD denn by default?

_______________________

Yay OpenZFS 2.0.0 ist fertig \o/ ❤

❤

https://github.com/openzfs/zfs/releases/tag/zfs-2.0.0

Was hat FreeBSD denn by default?

_______________________

Yay OpenZFS 2.0.0 ist fertig \o/

https://github.com/openzfs/zfs/releases/tag/zfs-2.0.0

Code: Alles auswählen

╔═╗┬ ┬┌─┐┌┬┐┌─┐┌┬┐╔╦╗

╚═╗└┬┘└─┐ │ ├┤ │││ ║║

╚═╝ ┴ └─┘ ┴ └─┘┴ ┴═╩╝ rockt das Forum!- Routerdilettantin

- Beiträge: 35

- Registriert: 09.11.2020 12:44:45

- Lizenz eigener Beiträge: GNU General Public License

Re: Allgemeiner ZFS unter Debian Faden.

Wenn ich das zu erklären wüsste, würde ich nicht fragen. Ich suche gern Unterschiede - aber wonach ich suchen soll, musst du schon etwas eingrenzen. Ein Posting von empfohlenen Kommandoein- und ausgaben traue ich mir noch zu.

- heisenberg

- Beiträge: 3565

- Registriert: 04.06.2015 01:17:27

- Lizenz eigener Beiträge: MIT Lizenz

Re: Allgemeiner ZFS unter Debian Faden.

Das ist eine konkrete Frage zu einem spezifischen Problem bzgl. ZFS und FreeBSD. Ich schlage vor, dafür einen neuen eigenen Thread aufzumachen und dies nicht im allgemeinen ZFS-Thread anzuhängen.

Jede Rohheit hat ihren Ursprung in einer Schwäche.

- Lord_Carlos

- Beiträge: 5578

- Registriert: 30.04.2006 17:58:52

- Lizenz eigener Beiträge: GNU Free Documentation License

- Wohnort: Dänemark

Re: Allgemeiner ZFS unter Debian Faden.

Ob ZFS gut mit stromausfall klar kommt kan man hier ja Fragen. Ich weis nur leider die Antwort nicht.

Ich wuerde einfach nehmen was bei pfSense default ist

_______________

Edit: Das hier kann sich lohnen zu lesen:

* https://www.reddit.com/r/PFSENSE/commen ... dvantages/

* https://www.reddit.com/r/PFSENSE/commen ... le_system/

ZFS scheint eine besser zu sein als UFS wenn es um powerloss geht.

Ich wuerde einfach nehmen was bei pfSense default ist

_______________

Edit: Das hier kann sich lohnen zu lesen:

* https://www.reddit.com/r/PFSENSE/commen ... dvantages/

* https://www.reddit.com/r/PFSENSE/commen ... le_system/

ZFS scheint eine besser zu sein als UFS wenn es um powerloss geht.

Code: Alles auswählen

╔═╗┬ ┬┌─┐┌┬┐┌─┐┌┬┐╔╦╗

╚═╗└┬┘└─┐ │ ├┤ │││ ║║

╚═╝ ┴ └─┘ ┴ └─┘┴ ┴═╩╝ rockt das Forum!Re: Allgemeiner ZFS unter Debian Faden.

Ich hab meine pfSensen mit ufs aufgesetzt. Die config wird regelmäßig per ssh abgeholt und wenn eine Platte abschmiert, wird flux neu installiert und die config auf nem usb stick bereitgestellt. Das ist so schnell gemacht, dass ich mir keine Gedanken über ZFS gemacht habe, bisher.

-

porn()pole

- Beiträge: 11

- Registriert: 05.12.2004 13:44:01

-

Kontaktdaten:

Re: Allgemeiner ZFS unter Debian Faden.

Hola Männer,

ich habe da so ein kleines administratives Problem mit meinem Debian Server - betrifft die Zugriffsrechte von Usern auf ZFS Datensätze.

Mit dem Befehl lässt sich ja "normalerweise" einstellen, dass auch ohne root-Rechte diese Befehle für definierte Pools und Datensätze ausgeführt werden dürfen.

Auf meinem Ubuntu Server (RP4B) lies sich dies auch anstandslos umsetzen, mein Standarduser darf dort snapshots senden und empfangen, ohne sudo.

Auf meinem eigentlichen Server (debian stable) zeigt er zwar per angeblich die selben Rechte an wie auf der Ubuntu-Maschine, weigert sich jedoch standhaft, diese Befehle ohne sudo auszuführen.

Irgendjemand eine Idee, wo der Haken ist?!

EDIT:

wayne, es liegt an der wie üblich alten Version von zfsutils unter debian stable. Diese ist < 6.8.x und kann somit mit zfs allow noch nicht vollständig umgehen.

ich habe da so ein kleines administratives Problem mit meinem Debian Server - betrifft die Zugriffsrechte von Usern auf ZFS Datensätze.

Mit dem Befehl

Code: Alles auswählen

zfs allow (user) send,receive,snapshot,hold,mount /pool/data Auf meinem Ubuntu Server (RP4B) lies sich dies auch anstandslos umsetzen, mein Standarduser darf dort snapshots senden und empfangen, ohne sudo.

Auf meinem eigentlichen Server (debian stable) zeigt er zwar per

Code: Alles auswählen

zfs allow pool/dataIrgendjemand eine Idee, wo der Haken ist?!

EDIT:

wayne, es liegt an der wie üblich alten Version von zfsutils unter debian stable. Diese ist < 6.8.x und kann somit mit zfs allow noch nicht vollständig umgehen.

■

Re: Allgemeiner ZFS unter Debian Faden.

Hey Freunde. Ich habe nun unter viel Aufwand, und ca. 1 Woche Probiererei, mein Sytem von 4x1TB mdadm RAID 0 auf ein RAID0 mit ZFS und native Encryption migriert, was echt schrecklich war bis das funktioniert hat.

Das ganze scheint aber nun echt prima zu funktionieren, ich habe nämlich einen Testing Daily, und daher kommt mir die Snapshot Funktion sehr zuvor.

Gerne hätte ich natürlich noch sowas, wenn das ohne schrecklich viel Aufwand realisierbar wäre. https://arstechnica.com/gadgets/2020/03 ... anagement/

Undzwar einen Abschnitt im GRUB Menü, mit dem man dann die Snapshots zurückrollen kann. Das wäre prima. Vielleicht weiß da ja einer was

Das ganze scheint aber nun echt prima zu funktionieren, ich habe nämlich einen Testing Daily, und daher kommt mir die Snapshot Funktion sehr zuvor.

Gerne hätte ich natürlich noch sowas, wenn das ohne schrecklich viel Aufwand realisierbar wäre. https://arstechnica.com/gadgets/2020/03 ... anagement/

Undzwar einen Abschnitt im GRUB Menü, mit dem man dann die Snapshots zurückrollen kann. Das wäre prima. Vielleicht weiß da ja einer was

-

DeletedUserReAsG

Re: Allgemeiner ZFS unter Debian Faden.

Manche Leute packen sich dafür ein angepasstes System auf die Platte, gerne auch ein Image eines Livesystems, das sie in dem Fall starten, um die gewünschten Änderungen von dort aus vorzunehmen.Knogle hat geschrieben:10.10.2021 21:39:26Gerne hätte ich natürlich noch […] einen Abschnitt im GRUB Menü, mit dem man dann die Snapshots zurückrollen kann.

Bei BTRFS konnte man im Grub den gewünschten Snapshot angeben, wenn ich mich nicht falsch erinnere.

Re: Allgemeiner ZFS unter Debian Faden.

Jup. rootflags=subvol=... muss man dann aber aus der fstab schmeißen und systemctl daemon-reload machn sonst nimmt er doch wieder das root-Device.niemand hat geschrieben:10.10.2021 21:58:57Bei BTRFS konnte man im Grub den gewünschten Snapshot angeben, wenn ich mich nicht falsch erinnere.

rot: Moderator wanne spricht, default: User wanne spricht.

Re: Allgemeiner ZFS unter Debian Faden.

Irgendwie habe ich manchmal das Problem dass ich in der initramfs Konsole lande beim Start, mit der Ausgabe "no such pools available". Dann muss ich mit zpool import -f den bpool und rpoo importen, und dann gehts, weil die angeblich auf einem anderen System gemountet waren.

Gibt es die Möglichkeit standardmäßig mit -f zu Importen um sowas zu vermeiden?

BTRFS werde ich auch mal in einer VM testen, sowas wird ja immerhin "standardmäßig" unterstützt

Gibt es die Möglichkeit standardmäßig mit -f zu Importen um sowas zu vermeiden?

BTRFS werde ich auch mal in einer VM testen, sowas wird ja immerhin "standardmäßig" unterstützt

Re: Allgemeiner ZFS unter Debian Faden.

Du kannst in /etc/initramfs-tools/conf.d/zfs folgenden Eintrag setzen ZFS_INITRD_POST_MODPROBE_SLEEP=10 damit sollte das Problem nicht mehr auftreten.Knogle hat geschrieben:11.10.2021 09:09:34Irgendwie habe ich manchmal das Problem dass ich in der initramfs Konsole lande beim Start, mit der Ausgabe "no such pools available". Dann muss ich mit zpool import -f den bpool und rpoo importen, und dann gehts, weil die angeblich auf einem anderen System gemountet waren.

Gibt es die Möglichkeit standardmäßig mit -f zu Importen um sowas zu vermeiden?

Re: Allgemeiner ZFS unter Debian Faden.

Werde ich mal probieren.

Bei der Verschlüsselung hätte ich ehrlich gesagt auch lieber LUKS benutzt statt ZFS Encryption. Aber ich denke dennoch, dass das ganze "Einbrechersicher" ist.

Bei LUKS hat mich genervt, dass ich 4x mein Passwort eingeben musste, da ich halt 4x 1TB SSDs habe, und die Volumes daher verteilt sind.

Was sind eigentlich so die großen Vor- und Nachteile von BTRFS gegenüber einem ZFS Setup als Daily?

Also die Snapshotfunktion musste ich direkt mal ausprobiere da ich nach einem Upgrade auf sid mein System zerschossen habe.

Bei der Verschlüsselung hätte ich ehrlich gesagt auch lieber LUKS benutzt statt ZFS Encryption. Aber ich denke dennoch, dass das ganze "Einbrechersicher" ist.

Bei LUKS hat mich genervt, dass ich 4x mein Passwort eingeben musste, da ich halt 4x 1TB SSDs habe, und die Volumes daher verteilt sind.

Was sind eigentlich so die großen Vor- und Nachteile von BTRFS gegenüber einem ZFS Setup als Daily?

Also die Snapshotfunktion musste ich direkt mal ausprobiere da ich nach einem Upgrade auf sid mein System zerschossen habe.

Re: Allgemeiner ZFS unter Debian Faden.

Das ist so nicht ganz richtig: SystemV konnte das. Mit nem akutellen grub2 und nem verschlüsselten boot gehts auch.Knogle hat geschrieben:11.10.2021 19:56:33Bei LUKS hat mich genervt, dass ich 4x mein Passwort eingeben musste, da ich halt 4x 1TB SSDs habe, und die Volumes daher verteilt sind.

* ZFS ist halt GPL-Inkompatibel und darf deswegen nicht zusammen ausliefern, was das recht umständlich zum einrichten macht.Knogle hat geschrieben:11.10.2021 19:56:33Was sind eigentlich so die großen Vor- und Nachteile von BTRFS gegenüber einem ZFS Setup als Daily?

* ZFS kann deduplication

* Die ZFS Kommandos sind aus dem Solaris Umfeld und haben ihre eigene Syntax und fühlen bestenfalls so wie die von LVM an. Die btrfs ähneln viel mehr denen der klassischen Linux Dateisysteme.

Kurz die ZFS Kommandos sind untereinander einheitlicher. Die btrfs-Kommandos einheitlicher mit dem Rest.

* ZFS kann RAID. Bei Btrfs ist nur RAID0 und RAID1 stabil.

* ZFS komprimiert nur auf Blockebene hat dafür den etwas besseren Kompressionsalgorithmus.

* ZFS nutzt ein anderes Caching. – Sehr vereinfach ist ZFS aggressiver und hält Dinge selbst dann im RAM, wenn andere Programme den RAM benutzen wollen, sodass die swappen müssen.

* ZFS kann nicht verkleinert werden

* Red Hat liefert Kernel ohne btrfs und will das auch nicht supporten.

* ZFS gibt es auch für Solaris BSD und OS X. btrfs nur für Linux und Windows.

* Btrfs kann Subvolumes.

rot: Moderator wanne spricht, default: User wanne spricht.

Re: Allgemeiner ZFS unter Debian Faden.

Hey danke dir!

Hat eigentlich jemand mal Benchmarks auf ZFS gemacht?

Meinen Pool auf meinem RAID Verbund möchte ich auflösen, habe dort ZFS Native Encryption aktiv, würde aber gerne den Pool auf meinen neuen ZFS Pool im LUKS Container "clonen".

Leider gestaltet sich das als maximal schwierig, von einem encrypted ZFS Pool, die Daten irgendwie auf den unverschlüsselten Pool zu kriegen.

Hat jemand dazu eine Idee? mit und scheint das nicht ohne weiteres möglich zu sein.

Oder muss ich die Dateien manuell bspw. mit Rsync rüberziehen?

Hat eigentlich jemand mal Benchmarks auf ZFS gemacht?

Meinen Pool auf meinem RAID Verbund möchte ich auflösen, habe dort ZFS Native Encryption aktiv, würde aber gerne den Pool auf meinen neuen ZFS Pool im LUKS Container "clonen".

Leider gestaltet sich das als maximal schwierig, von einem encrypted ZFS Pool, die Daten irgendwie auf den unverschlüsselten Pool zu kriegen.

Hat jemand dazu eine Idee? mit

Code: Alles auswählen

zfs sendCode: Alles auswählen

zfs recvOder muss ich die Dateien manuell bspw. mit Rsync rüberziehen?

Re: Allgemeiner ZFS unter Debian Faden.

Mit zfs send und zfs recv geht das ohne Probleme, wie gehst du denn im Detail vor?

Re: Allgemeiner ZFS unter Debian Faden.

Ich will im Grunde rekursiv alle Datasets zum neuen Pool schieben der unencrypted ist.bluestar hat geschrieben:31.10.2021 19:36:19Mit zfs send und zfs recv geht das ohne Probleme, wie gehst du denn im Detail vor?

Also im Grunde alles was auf dem pool "rpool" ist, soll auf den Pool "rpool0" drauf.

Hier mal ein

Code: Alles auswählen

zfs listCode: Alles auswählen

root@debian:/home/chairman# zfs list

NAME USED AVAIL REFER MOUNTPOINT

bpool 408M 3.23G 96K /boot

bpool/BOOT 394M 3.23G 96K none

bpool/BOOT/debian 394M 3.23G 168M /boot

rpool 2.44T 1.08T 192K /

rpool/ROOT 20.2G 1.08T 192K none

rpool/ROOT/debian 20.2G 1.08T 17.4G /

rpool/home 2.37T 1.08T 2.17T /home

rpool/home/root 4.87M 1.08T 1.25M /root

rpool/opt 1.60G 1.08T 1.16G /opt

rpool/swap 34.0G 1.11T 116K -

rpool/tmp 5.35M 1.08T 1.73M /tmp

rpool/usr 19.1M 1.08T 192K /usr

rpool/usr/local 18.9M 1.08T 11.7M /usr/local

rpool/var 7.30G 1.08T 192K /var

rpool/var/cache 2.90G 1.08T 2.90G /var/cache

rpool/var/games 196K 1.08T 196K /var/games

rpool/var/lib 2.84M 1.08T 192K /var/lib

rpool/var/lib/AccountsService 2.65M 1.08T 248K /var/lib/AccountsService

rpool/var/log 4.35G 1.08T 1.35G /var/log

rpool/var/spool 6.47M 1.08T 308K /var/spool

rpool/var/tmp 34.4M 1.08T 34.3M /var/tmpMit einem mdadm RAID 0 und XFS komme ich auf 6GB/s.

Liegt das vielleicht daran, dass die ZFS Native Encryption im Gegensatz zu LUKS nicht hardwarebeschleunigt ist? Oder kann das an ZFS "liegen"?

Re: Allgemeiner ZFS unter Debian Faden.

Eigentlich sollte das so klappen:Knogle hat geschrieben:31.10.2021 20:32:11

Ich will im Grunde rekursiv alle Datasets zum neuen Pool schieben der unencrypted ist.

Also im Grunde alles was auf dem pool "rpool" ist, soll auf den Pool "rpool0" drauf.

Code: Alles auswählen

zfs send rpool/ROOT | zfs receive -o encryption=off rpool0/ROOT

* rpool/home

* rpool/opt

* rpool/swap

* rpool/tmp

* rpool/usr

* rpool/var

Da wären ein paar Hardware-Facts und auch mal eine genaue Kopierbeschreibung sinnvoll.Knogle hat geschrieben:31.10.2021 20:32:11Aktuell unter meinem Debian RAID 0 Pool mit ZFS ist die Performance ziemlich begrenzt. Wenn ich eine mit /dev/urandom 16G erzeugte Datei kopiere ist das ganze unterirdisch.

Eine Vermutung hab ich schon mal, dass hier statt kopiert nur Blocks neu referenziert werden um das genau zu analysieren müsstest du deinen Vergleichsaufbau exakt skizzieren.

Welche ZFS Version nutzt du denn?Knogle hat geschrieben:31.10.2021 20:32:11Liegt das vielleicht daran, dass die ZFS Native Encryption im Gegensatz zu LUKS nicht hardwarebeschleunigt ist? Oder kann das an ZFS "liegen"?

Re: Allgemeiner ZFS unter Debian Faden.

Vielen Dank, das werde ich mal probieren!!

Zu meinem Aufbau:

Jetzt in meinem System aktuell habe ich 4x NVMe SSDs vom Typ Seagate FireCuda 510 1TB. Die sind alle jeweils mit 4x PCIe 3.0 Lanes angebunden.

Der ZFS Pool wurde wie folgt erzeugt, und geht als stripe über die 4 SSDs.

ist bei mir nicht als tmpfs gemountet, sondern auf der Platte.

Daher habe ich in meinen Tests 3x eine 16GB Datei mit erstellt, und 3x mit .

Die habe ich dann von auf kopiert.

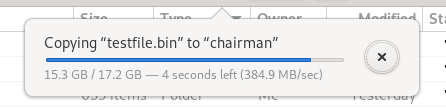

sagt

Was weiterhin ziemlich dauert: Ich mülle /tmp ziemlich oft mit Buildprojekten zu, da ich froh bin, dass nach dem nächsten Start der Ordner wieder leer ist. Wie zuvor beim "Vanilla" Debian, ist mein /tmp nicht als tmpfs gemountet. Das Problem jedoch: Je nachdem wieviel da drin ist, dauert das löschen des Inhalts aus dem /tmp Ordner manchmal bis zu 1:30 Minuten. Beim ext4 war das aus irgendeinem Grund nie in Form irgendeiner Verzögerung beim Startvorgang spürbar. Kommt man also für /tmp doch nicht um ein tmpfs drum herum bei ZFS?

Zu meinem Aufbau:

Jetzt in meinem System aktuell habe ich 4x NVMe SSDs vom Typ Seagate FireCuda 510 1TB. Die sind alle jeweils mit 4x PCIe 3.0 Lanes angebunden.

Der ZFS Pool wurde wie folgt erzeugt, und geht als stripe über die 4 SSDs.

Code: Alles auswählen

zpool create \

-o ashift=12 \

-O encryption=aes-256-gcm \

-O keylocation=prompt -O keyformat=passphrase \

-O acltype=posixacl -O canmount=off -O compression=lz4 \

-O dnodesize=auto -O normalization=formD -O relatime=on \

-O xattr=sa -O mountpoint=/ -R /mnt \

rpool /dev/nvme[0-3]n1p4Code: Alles auswählen

/tmpDaher habe ich in meinen Tests 3x eine 16GB Datei mit

Code: Alles auswählen

/dev/urandomCode: Alles auswählen

/dev/zeroDie habe ich dann von

Code: Alles auswählen

/tmpCode: Alles auswählen

/homeCode: Alles auswählen

sudo modinfo zfs | grep version

Code: Alles auswählen

version: 2.0.3-9

srcversion: 589A10A280F2E97C4C1E9F6

vermagic: 5.10.0-9-amd64 SMP mod_unload modversions

Re: Allgemeiner ZFS unter Debian Faden.

in dem ZFS sind /home (rpool/home) und /tmp (rpool/tmp) zwei unterschiedliche Dateisysteme, du könntest mal von /tmp nach /tmp deine Testdateien kopieren und die Performance messen, das sollte deutlich schneller sein als von /tmp nach /home zu kopieren.Knogle hat geschrieben:01.11.2021 11:10:20ist bei mir nicht als tmpfs gemountet, sondern auf der Platte.Code: Alles auswählen

/tmp

Daher habe ich in meinen Tests 3x eine 16GB Datei miterstellt, und 3x mitCode: Alles auswählen

/dev/urandom.Code: Alles auswählen

/dev/zero

Die habe ich dann vonaufCode: Alles auswählen

/tmpkopiert.Code: Alles auswählen

/home

Re: Allgemeiner ZFS unter Debian Faden.

Ah herzlichen Dank für den Hinweis. Was passiert da genau wenn man von einem Dataset auf ein anders schreibt?

Also wenn ich von /tmp auf /tmp schreibe, liege ich ebenfalls wie bei dem mdadm RAID0 bei ca. 5,4GB/s.

Ich bin gerade wieder bei dem Kopierproblem dabei.

Mit werden auf dem Zielpool nur leere Datasets erstellt.

Was ich gestern probiert habe:

Das Problem dabei: Der wollte dann bei jedem der neuen Zielpools einen Key für Encryption haben.

geht leider auch nicht, dann mackert er mit folgender Meldung.

Auch mit klappt das nicht da ich die Encryption wohl nicht rauskriege.

Bei zfs send muss ich -w für Raw nutzen, da man laut der dortigen Fehlermeldugn keine encrypted Pools ohne -w für Raw übertragen kann.

Also wenn ich von /tmp auf /tmp schreibe, liege ich ebenfalls wie bei dem mdadm RAID0 bei ca. 5,4GB/s.

Ich bin gerade wieder bei dem Kopierproblem dabei.

Mit

Code: Alles auswählen

zfs send rpool/ROOT | zfs receive -o encryption=off rpool0/ROOTWas ich gestern probiert habe:

Code: Alles auswählen

zfs send -v -w -R rpool/home@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/home/root@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/var@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/var/cache@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/var/games@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/var/log@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/tmp@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/opt@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/swap@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/usr@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R rpool/usr/local@umzug1 | zfs recv -v -d rpool0

zfs send -v -w -R bpool/BOOT@umzug1 | zfs recv -v -d bpool0

zfs send -v -w -R bpool/BOOT@umzug1 | zfs recv -v -d -F bpool0

zfs send -v -w -R bpool/BOOT/debian@umzug1 | zfs recv -v -d -F bpool0

Code: Alles auswählen

-o encryption=offCode: Alles auswählen

receiving full stream of rpool/home@zfs-auto-snap_daily-2021-10-11-0711 into rpool0/home@zfs-auto-snap_daily-2021-10-11-0711

cannot receive new filesystem stream: encryption property 'encryption' cannot be set or excluded for raw streams.Code: Alles auswählen

-x encryptionBei zfs send muss ich -w für Raw nutzen, da man laut der dortigen Fehlermeldugn keine encrypted Pools ohne -w für Raw übertragen kann.

Re: Allgemeiner ZFS unter Debian Faden.

Du musst dir jedes ZFS Dataset wie ein eigenes Dateisystem auf einer Platte vorstellen, innerhalb des Datasets wird mit Referenzen kopiert (=schnell) und sobald Daten das Dataset verlassen, müssen diese echt dupliziert werden, was natürlich entsprechend länger dauert.Knogle hat geschrieben:01.11.2021 11:50:13Ah herzlichen Dank für den Hinweis. Was passiert da genau wenn man von einem Dataset auf ein anders schreibt?

Also wenn ich von /tmp auf /tmp schreibe, liege ich ebenfalls wie bei dem mdadm RAID0 bei ca. 5,4GB/s.

Ich bin gerade wieder bei dem Kopierproblem dabei.

Re: Allgemeiner ZFS unter Debian Faden.

Also -R und -w kannst du nicht verwenden, wenn du die Verschlüsselung beim Empfang deaktivieren möchtest, versuch es mal ohne.Knogle hat geschrieben:01.11.2021 11:50:13

Was ich gestern probiert habe:

Code: Alles auswählen

zfs send -v -w -R rpool/home@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/home/root@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/var@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/var/cache@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/var/games@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/var/log@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/tmp@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/opt@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/swap@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/usr@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R rpool/usr/local@umzug1 | zfs recv -v -d rpool0 zfs send -v -w -R bpool/BOOT@umzug1 | zfs recv -v -d bpool0 zfs send -v -w -R bpool/BOOT@umzug1 | zfs recv -v -d -F bpool0 zfs send -v -w -R bpool/BOOT/debian@umzug1 | zfs recv -v -d -F bpool0

Re: Allgemeiner ZFS unter Debian Faden.

Hey danke, ich habe es am Ende hingekriegt indem ich das ganze mit rsync auf einen neuen Pool geschoben habe, und von dort dann wieder zurück.

Gibt es eigentlich jemanden der wieder zurück auf ein "normales" Dateisystem gewechselt ist, nach einem Exkurs zu ZFS?

Ich persönlich habe schon ein paar mal vom ZFS Snapshot Feature gebraucht gemacht, indem ich ab und zu mal einen Rollback machen musste, nachdem apt nach irgendeinem Update ein benötigtes ZFS Paket entfernt habe. Aber sonst aktuell nicht.

Deswegen werde ich wohl für meinen Daily wieder zurück auf EXT4/XFS wechseln, und ZFS wird bei mir dem TrueNAS Server und der pfSense vorbehalten bleiben.

Gibt es eigentlich jemanden der wieder zurück auf ein "normales" Dateisystem gewechselt ist, nach einem Exkurs zu ZFS?

Ich persönlich habe schon ein paar mal vom ZFS Snapshot Feature gebraucht gemacht, indem ich ab und zu mal einen Rollback machen musste, nachdem apt nach irgendeinem Update ein benötigtes ZFS Paket entfernt habe. Aber sonst aktuell nicht.

Deswegen werde ich wohl für meinen Daily wieder zurück auf EXT4/XFS wechseln, und ZFS wird bei mir dem TrueNAS Server und der pfSense vorbehalten bleiben.